Le fichier robots.txt sur WordPress, c’est tout petit, mais ça peut faire des dégâts si c’est mal fichu. Il mérite clairement qu’on s’y intéresse deux minutes.

En audit SEO, ça m’arrive de tomber sur des robots.txt mal configurés. Ce n’est pas tous les jours, mais quand c’est le cas, ça peut bloquer l’indexation de pages importantes. Et là… bad buzz.

Alors si tu veux éviter les erreurs bêtes et donner un vrai coup de boost à ton référencement WordPress, t’es au bon endroit !

C’est quoi un fichier robots.txt (et à quoi ça sert) ?

Le fichier robots.txt, c’est un simple fichier texte placé à la racine de ton site WordPress. Il sert à donner des instructions aux robots des moteurs de recherche comme Google, Bing ou Yahoo. En gros, tu leur dis ce qu’ils peuvent explorer… et ce qu’ils doivent éviter.

Quand j’ai découvert ce fichier au début, je t’avoue que ça m’a semblé un peu technique. Mais aujourd’hui, je l’explique simplement à mes clients : c’est un peu le videur de ton site. Il laisse entrer certains robots dans certaines pages, et il bloque l’accès aux autres.

Tu veux éviter que Google perde son temps à explorer ton dossier /wp-admin/ ou les répertoires sensibles ? Tu lui dis gentiment Disallow: /wp-admin/, et il respecte (en général).

Attention cependant : bloquer une page via robots.txt ne veut pas dire qu’elle ne sera jamais indexée. Si cette page est liée ailleurs, elle peut quand même apparaître dans les résultats, sans son contenu. C’est pourquoi Google recommande d’utiliser la balise meta noindex si tu veux vraiment éviter l’indexation.

👉 Voir les explications officielles ici.

Bref, le fichier robots.txt ne remplace pas une stratégie SEO… mais il en fait clairement partie. Et sur WordPress, mieux vaut le configurer proprement pour éviter les mauvaises surprises.

En résumé 💡

Le fichier robots.txt, c’est un petit fichier texte placé à la racine de ton site WordPress. Il sert à dire aux robots des moteurs de recherche quelles pages ils peuvent ou non explorer. Bien configuré, il évite que Google perde du temps sur des pages inutiles… et t’aide à concentrer ton SEO là où ça compte.

Comment WordPress gère (ou ne gère pas) le fichier robots.txt par défaut ?

Sur WordPress, si tu tapes tonsite.com/robots.txt (exemple : celui de mon site), tu verras un fichier… même si tu n’en as jamais créé. C’est normal : WordPress génère un fichier robots.txt virtuel par défaut.

Mais ce fichier est basique. Il bloque juste l’accès au dossier /wp-admin/. Et tu ne peux pas vraiment le modifier sans passer par un plugin ou un fichier physique.

Personnellement, j’utilise Rank Math. C’est pour moi le meilleur plugin SEO sur WordPress. Il est clair, simple à prendre en main, et surtout… tu peux éditer ton fichier robots.txt directement depuis ton interface WordPress, sans prise de tête.

Évidemment, tu peux aussi créer un fichier robots.txt à la main, en FTP. Mais pour mes clients (et pour moi), le plugin reste la solution la plus pratique.

Le conseil de Guillaume 💡

Ne fais pas aveuglément confiance à WordPress pour gérer ton fichier robots.txt. Par défaut, il en génère un dynamique, mais tu n’as quasiment aucun contrôle dessus. Si tu veux vraiment piloter ton SEO, prends quelques minutes pour le personnaliser. C’est simple, et ça peut éviter de gros loupés dans l’indexation.

Les règles à connaître pour créer un bon fichier robots.txt WordPress

Quand on veut optimiser son SEO WordPress, le fichier robots.txt est une petite ligne de défense super utile. Bien configuré, il empêche les moteurs de recherche comme Google d’explorer certaines zones inutiles de ton site. Mal configuré, il peut bloquer des pages importantes… et plomber ton référencement.

Voici quelques règles simples et efficaces que j’utilise souvent :

✅ Exemple de fichier robots.txt WordPress propre

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-includes/

Disallow: /cgi-bin/

Disallow: /wp-content/plugins/

Disallow: /wp-content/cache/

Disallow: /wp-content/themes/

Disallow: /trackback/

Disallow: /feed/

Disallow: */comments

Sitemap: https://tonsite.com/sitemap_index.xml🔍 Ce que ça fait concrètement :

- User-agent: * → ça s’adresse à tous les robots (Googlebot, Bingbot, etc.)

- Disallow: /wp-admin/ → on bloque l’accès au panneau d’admin (classique)

- Allow: /wp-admin/admin-ajax.php → on autorise les requêtes AJAX utiles au site

- Disallow: /wp-includes/ et autres → on empêche l’exploration de fichiers techniques ou inutiles

- Sitemap → on indique à Google où trouver la carte du site

3 façons de créer ou modifier ton fichier robots.txt

Tu veux créer ou modifier ton fichier robots.txt WordPress ? Bonne nouvelle : t’as plusieurs options. Certaines sont hyper simples, d’autres un poil plus techniques. Je t’explique tout.

Méthode 1 : Avec un plugin SEO (Yoast, Rank Math…)

C’est clairement la solution que je recommande à mes clients. Surtout si tu utilises déjà un plugin SEO comme Rank Math (mon préféré) ou Yoast SEO.

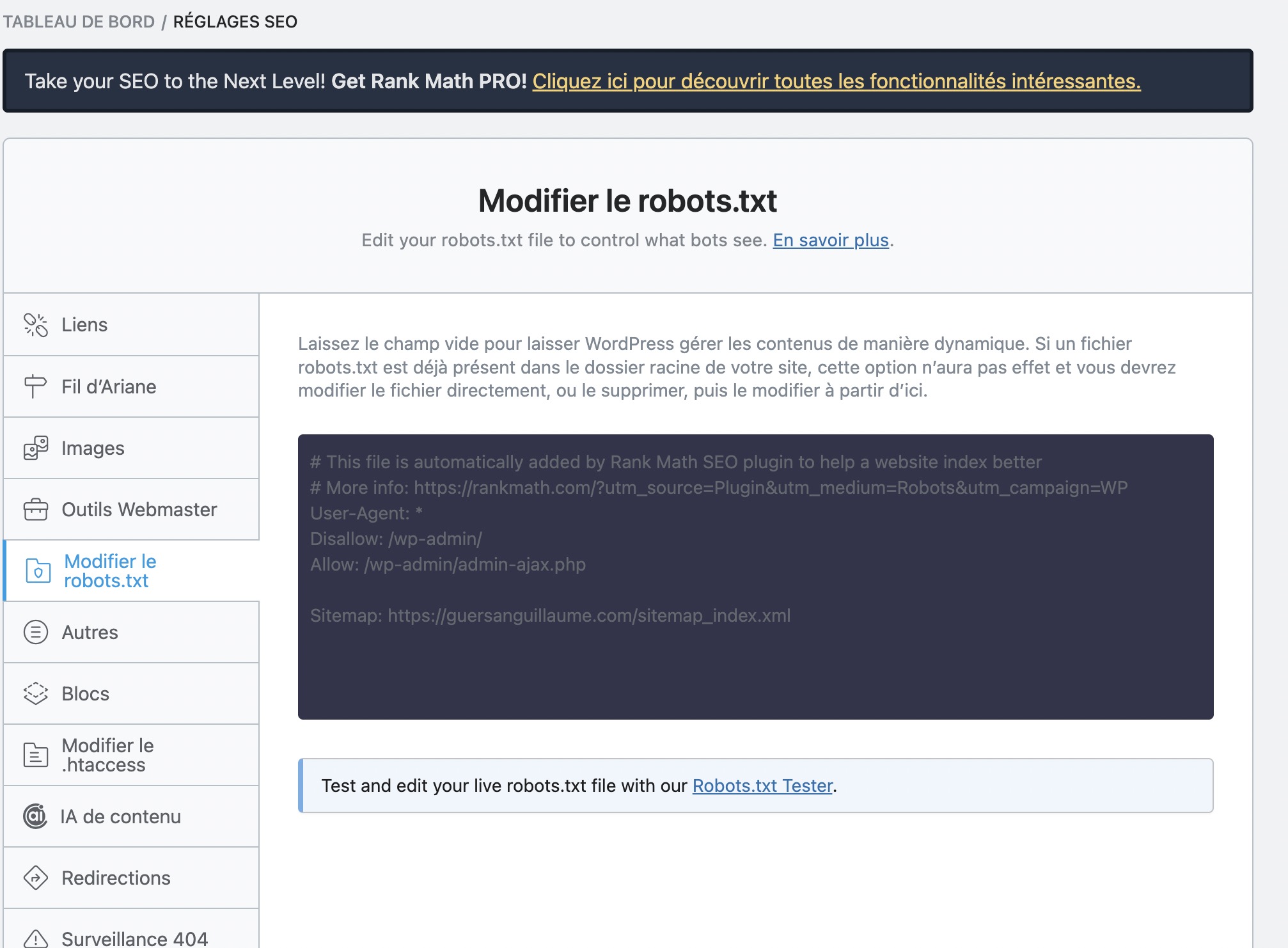

Avec Rank Math par exemple, tu peux modifier ton fichier robots.txt directement depuis l’interface WordPress. T’as même un aperçu en temps réel. Simple, rapide, sans risque de casser quoi que ce soit.

👉 Voici la doc officielle de Rank Math pour modifier ton robots.txt

Voici ce que cela donne sur RankMath sur mon site :

Méthode 2 : En FTP (rapide si tu sais faire)

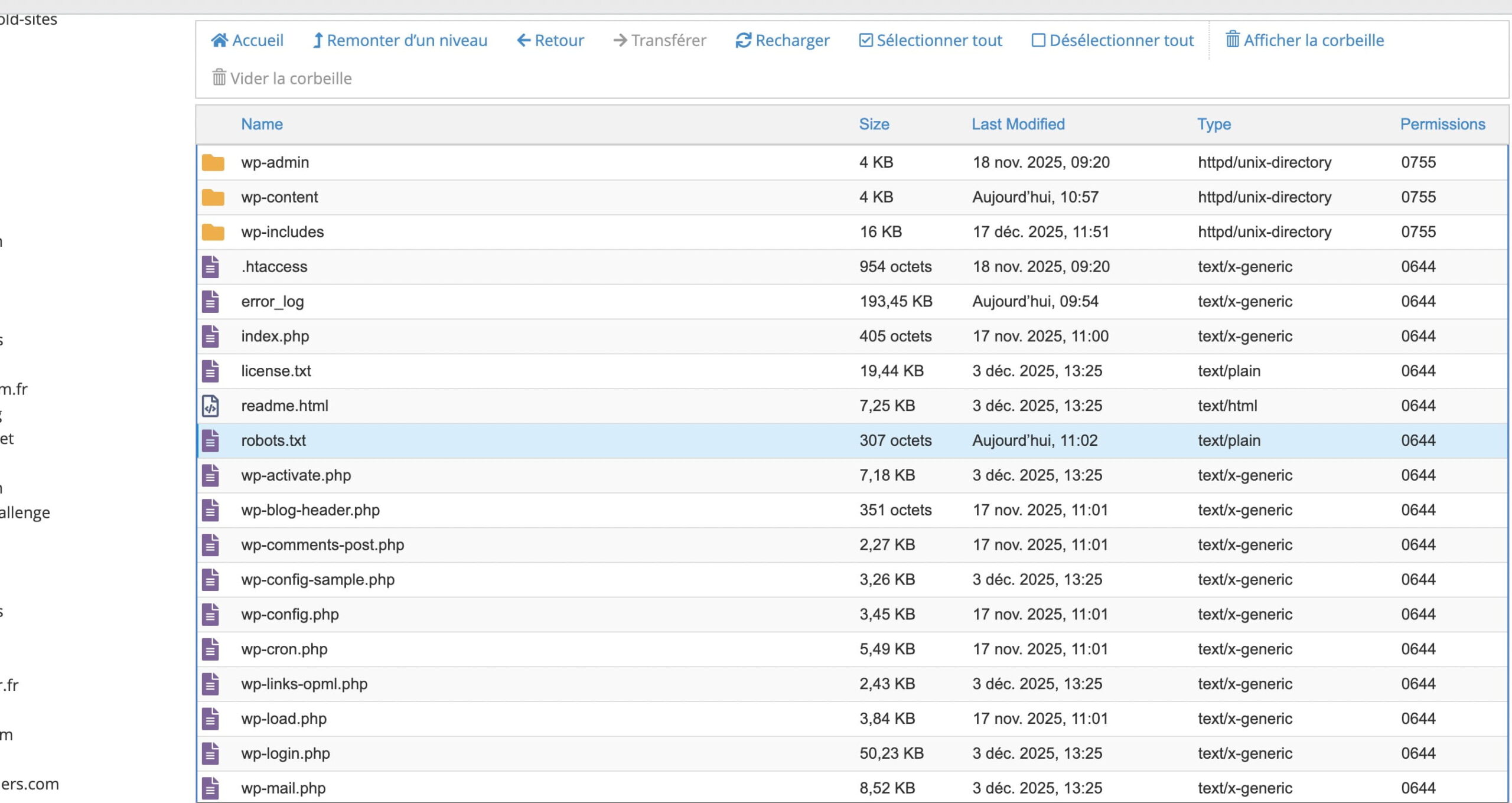

Tu peux aussi créer ou modifier ton fichier robots.txt à la main, via un logiciel FTP comme FileZilla.

Tu te connectes à la racine de ton site (là où y a le fichier wp-config.php), tu crées un fichier robots.txt avec Notepad++, Sublime Text (ou même le Bloc-Notes), tu colles tes règles, tu uploades… et c’est en ligne.

Voici ce que ça donne :

Méthode 3 : Depuis l’hébergeur ou un éditeur de fichiers

Certains hébergeurs (comme o2switch, OVH, Hostinger, Kinsta…) proposent un éditeur de fichiers dans leur interface. C’est un peu comme le FTP, mais directement depuis ton espace client.

Tu vas dans le gestionnaire de fichiers, tu ouvres ou crées le fichier robots.txt, tu édites… et c’est bon.

o2switch a une interface web pour modifier les fichiers :

Quelle que soit la méthode, n’oublie pas de tester ton fichier derrière, pour être sûr qu’il n’empêche pas Google d’indexer tes pages clés. Et si t’as un doute… fais-toi accompagner.

Comment tester et optimiser ton fichier robots.txt ?

Une fois que ton fichier robots.txt WordPress est en place, c’est pas fini. Il faut le tester et l’optimiser. Parce que même une petite erreur peut empêcher Google d’indexer des pages importantes… et flinguer ton SEO.

Voici comment je procède.

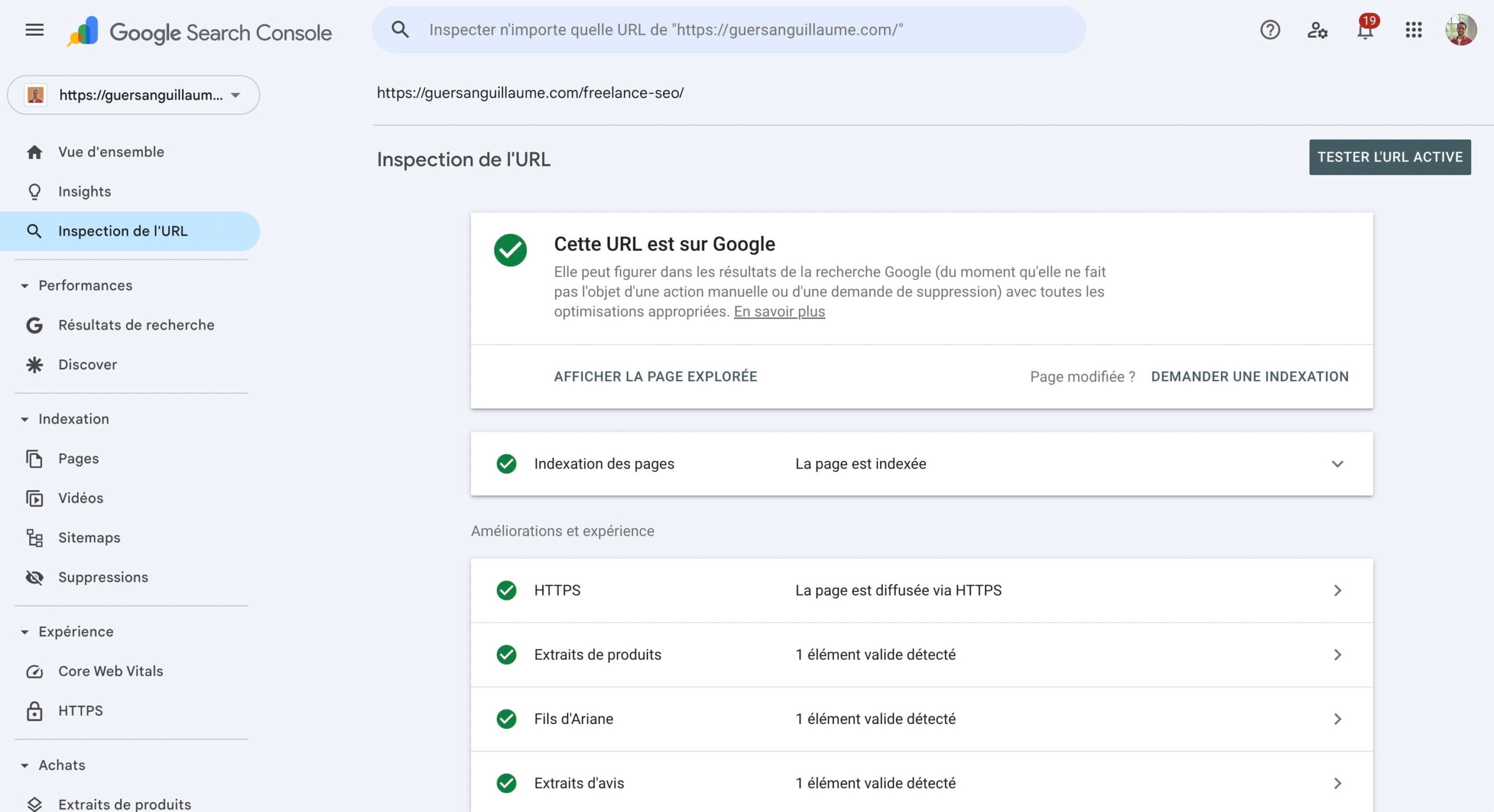

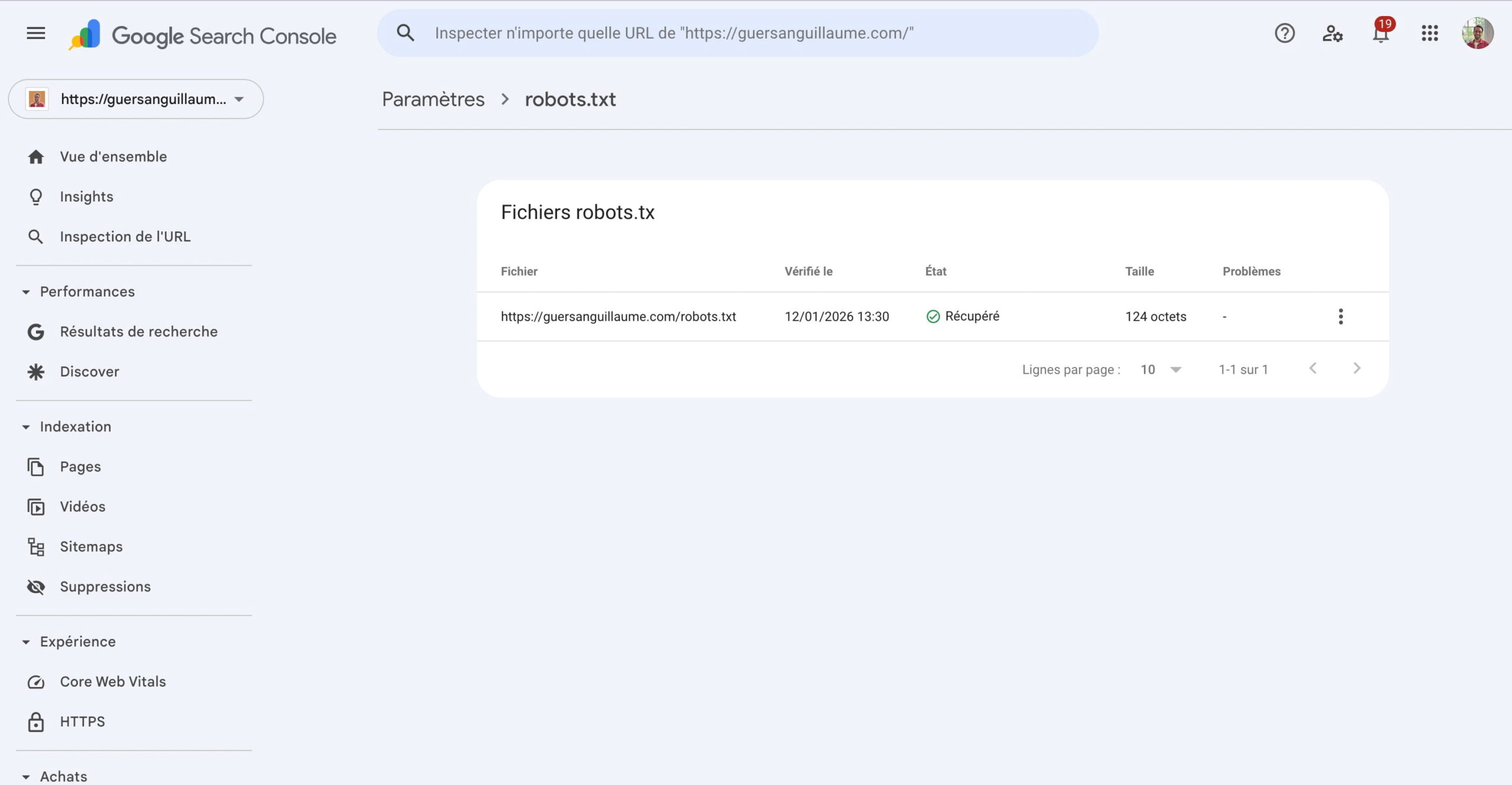

1. Vérifie avec la Google Search Console

Le premier réflexe, c’est d’aller dans Google Search Console, dans l’outil d’inspection d’URL.

Tu colles une page importante de ton site (comme une page de service ou un article), et tu regardes si elle est bien explorée et indexée. Si ce n’est pas le cas, un message du genre « bloquée par le fichier robots.txt » s’affichera.

C’est l’endroit idéal pour détecter une erreur de Disallow mal placée.

2. Utilise un outil pour simuler les robots

Tu peux aussi utiliser des outils comme :

- Robots.txt Tester (via GSC)

- Cuik SEO (le meilleur outil d’audit SEO)

- Ou un crawler comme Screaming Frog

Tu verras rapidement quelles pages sont bloquées et comment les robots comme Googlebot ou Bingbot réagissent.

3. Optimise ton fichier régulièrement

Ton site évolue ? Ton robots.txt aussi. Dès que tu ajoutes un plugin, une section ou un nouveau dossier, pense à vérifier si ça impacte l’exploration du site.

Voici quelques petites optimisations que j’applique souvent :

- Supprimer les Disallow inutiles

- Ajouter l’URL du sitemap (très important pour Google)

- Corriger des règles trop larges comme Disallow: /wp- (ça bloque trop de trucs utiles)

🛠️ Un robots.txt, c’est pas « on le fait une fois et on n’y touche plus ». C’est un fichier vivant, à surveiller comme n’importe quel élément clé du SEO.

Et si je t’aidais à vraiment faire décoller ton SEO WordPress ?

Le fichier robots.txt, c’est qu’un détail. Mais c’est souvent là que le SEO se joue.

Je suis freelance SEO, et j’accompagne les pros du web, freelances et PME à améliorer leur visibilité sur Google. Mon accompagnement démarre toujours par un audit complet, puis on construit une stratégie claire, efficace, et adaptée à ton site WordPress.

Pas de blabla. Que du concret. Tu veux qu’on avance ensemble ? Parlons-en.

À retenir 💬

Le fichier robots.txt WordPress, c’est un tout petit bout de code… mais avec un impact énorme sur ton SEO. Bien configuré, il guide Google dans les bonnes directions. Mal fait, il peut te faire rater des opportunités. Si tu veux être sûr de ne pas te louper, ou si tu veux aller plus loin dans l’optimisation de ton site, je suis là pour t’accompagner.

FAQ

Où se trouve le fichier robots.txt dans WordPress ?

Par défaut, WordPress ne crée pas physiquement de fichier robots.txt dans les dossiers du site, mais il en génère un virtuellement. Tu peux le voir en ajoutant /robots.txt à la fin de ton nom de domaine. Si tu veux le modifier, il faut passer par un plugin SEO ou créer un fichier à la racine du site via FTP.

WordPress crée-t-il un fichier robots.txt par défaut ?

Oui, mais il est généré dynamiquement. Ce fichier virtuel contient quelques règles basiques comme le blocage de /wp-admin/, mais tu ne le vois pas dans les fichiers de ton site à moins d’en créer un toi-même.

Comment modifier le fichier robots.txt sur WordPress ?

Le plus simple, c’est d’utiliser un plugin SEO comme Rank Math ou Yoast. Sinon, tu peux créer un fichier texte appelé robots.txt et l’ajouter à la racine de ton site via FTP ou via le gestionnaire de fichiers de ton hébergeur.

Le fichier robots.txt est-il bénéfique pour le référencement naturel ?

Oui, s’il est bien utilisé. Il permet d’éviter que les moteurs de recherche gaspillent du temps sur des pages inutiles et leur montre où aller en priorité, ce qui améliore l’exploration et donc le SEO global du site.

Est-ce grave d’avoir un fichier robots.txt mal configuré ?

Oui, car une erreur peut bloquer l’indexation de pages importantes ou, au contraire, laisser explorer des zones sensibles. C’est un petit fichier, mais il peut avoir de grosses conséquences sur ton référencement.

Quelle est la différence entre Disallow, Allow et noindex ?

Disallow empêche les robots d’explorer une URL, Allow les autorise dans certains cas malgré un blocage plus large, et noindex demande de ne pas indexer une page, mais il doit être utilisé dans le code HTML et non dans le fichier robots.txt.

Dois-je utiliser le fichier robots.txt ou la balise meta ?

Les deux peuvent être utiles, mais ils ne font pas la même chose. Le fichier robots.txt bloque l’accès avant même l’exploration, tandis que la balise meta agit après l’exploration. Pour désindexer une page, la meta noindex est plus fiable.

Dois-je bloquer /wp-admin/ dans mon fichier robots.txt ?

Oui, c’est une bonne pratique courante. Cela empêche les moteurs de recherche d’explorer l’espace d’administration de ton site, qui n’a aucun intérêt pour les utilisateurs dans les résultats de recherche.

Faut-il inclure un sitemap dans le fichier robots.txt ?

Oui, c’est recommandé. Cela permet d’indiquer directement aux moteurs de recherche où trouver la structure complète de ton site, ce qui facilite leur travail d’indexation.

Comment tester si mon fichier robots.txt fonctionne correctement ?

Tu peux simplement saisir l’URL de ton fichier dans le navigateur ou utiliser un outil en ligne pour simuler l’exploration par les robots. L’important est de vérifier que les bonnes pages sont bien bloquées ou accessibles selon ce que tu as défini.